La curiosità del mese a cura di Tomaso Belloni

Il 10 aprile 2019 è stata presentata al mondo la prima immagine di un buco nero.

In questa “curiosità” vorrei allontanarmi momentaneamente dall’astronomia per fare chiarezza sulla inane discussione sul fatto che la prima immagine di un buco nero, al centro della galassia M87, sia o non sia una foto.

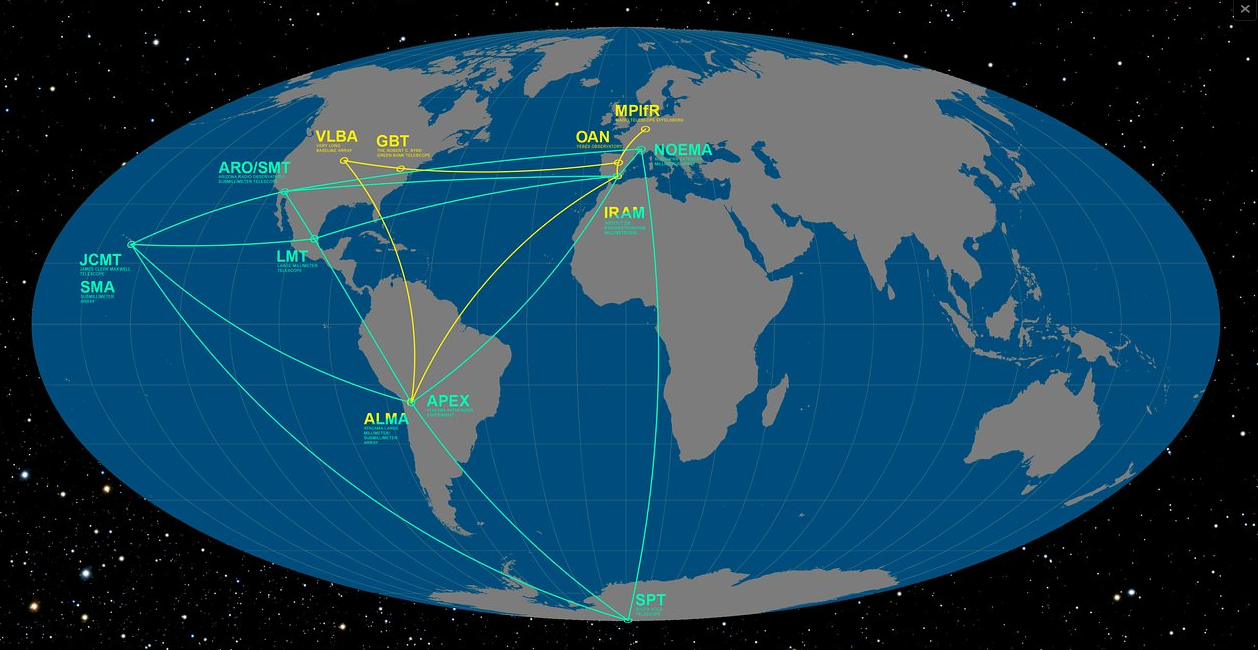

Per prima cosa i fatti: l’immagine (anzi, le immagini) che sono state rese pubbliche sono state ottenute con una rete planetaria di radiotelescopi.

Un radiotelescopio è un’antenna sensibile alle onde radio ad una certa frequenza.

Quello che registra è l’intensità dell’emissione radio in una certa, ridotta, porzione di cielo.

Se si vuole ottenere un’immagine bisogna fare dei passaggi multipli nella zona da osservare e poi ricostruire l’immagine.

Nel caso di una rete di telescopi come appunto l’Event Horizon Telescope (EHT), i dati dei vari radiotelescopi devono essere analizzati insieme.

Grazie al fatto che i radiotelescopi sono lontani fra loro, si possono utilizzare tecniche di interferometria basate sul fatto che la distanza dei radiotelescopi dalla sorgente non è la stessa. In questo modo i vari telescopi funzionano come un unico grande telescopio grande quanto la separazione fra le unità singole e quindi la sua risoluzione spaziale è molto più alta (il fiammifero sulla luna di cui ha parlato Gabriele Ghisellini – vedi curiosità di giugno 2019).

I conti sono molto, molto più complessi, ma si tratta anche qui di una ricostruzione.

Se per “fotografia” si intende l’analogo di un “selfie” scattato con il cellulare, qui non si può parlare di fotografia.

Ma quando si può parlare di fotografia e cos’è una fotografia?

Fino ad una ventina di anni fa, si esponevano pellicole fotosensibili alla luce, poco importa se l’apparecchio fosse una fotocamera reflex all’avanguardia o una scatola per scarpe con un buco (ovvero una fotocamera a foro stenopeico – a questo proposito cliccate qui per andare all’Astronomy Picture Of the Day del 27 giugno 2019).

Poi si sviluppava e fissava l’immagine in camera oscura, operazione che per semplicità qui considererò banale.

Poi veniva il momento della stampa, ovvero l’esposizione alla proiezione del negativo di una carta fotosensibile e qui le possibilità operative erano infinite.

Anche ignorando le caratteristiche dello scatto e la possibilità di usare filtri, le possibilità di stampa erano infinite e un fotografo professionale aveva molto gioco su questa procedura.

La foto risultante era una rappresentazione fedele della realtà e che cosa si intende per rappresentazione della realtà?

Non entriamo in questa discussione che ci porterebbe lontano, perlomeno allora non si usavano computer. Passiamo ai giorni nostri.

Ora si usano fotocamere digitali, che siano in uno smartphone o in una fotocamera professionale.

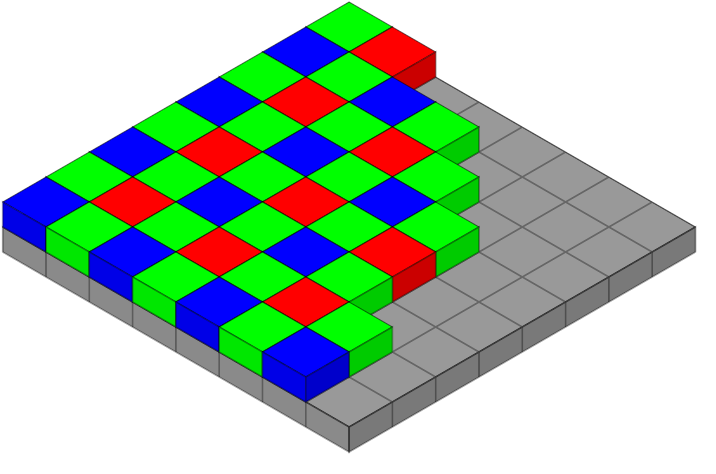

La luce viene focalizzata su uno strumento detto CMOS dotato di milioni (mega-) di pixel, quadratini sensibili alla luce, che accumulano una carica proporzionale all’intensità luminosa che li colpisce.

Solo che un CMOS non distingue i colori, registra un’immagine per così dire in bianco e nero.

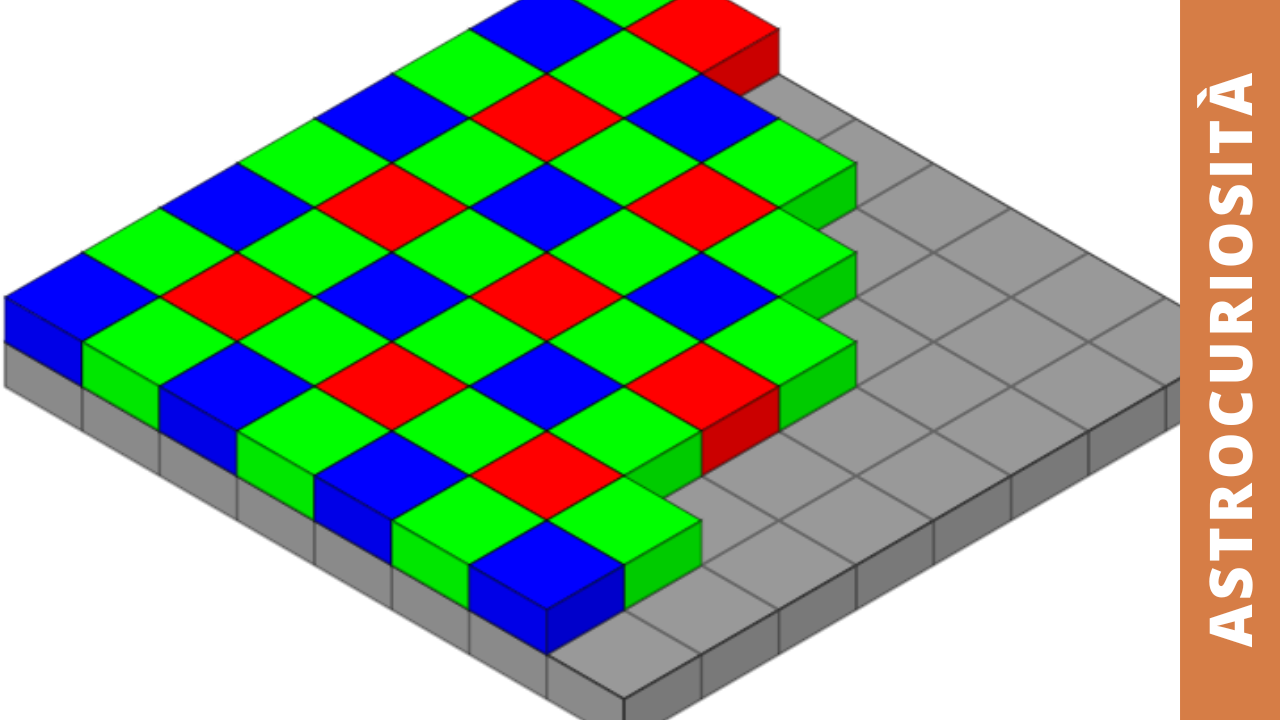

Per ottenere informazioni sui colori, ognuno dei milioni di pixel ha davanti a sé un filtro, che può essere rosso, verde o blu.

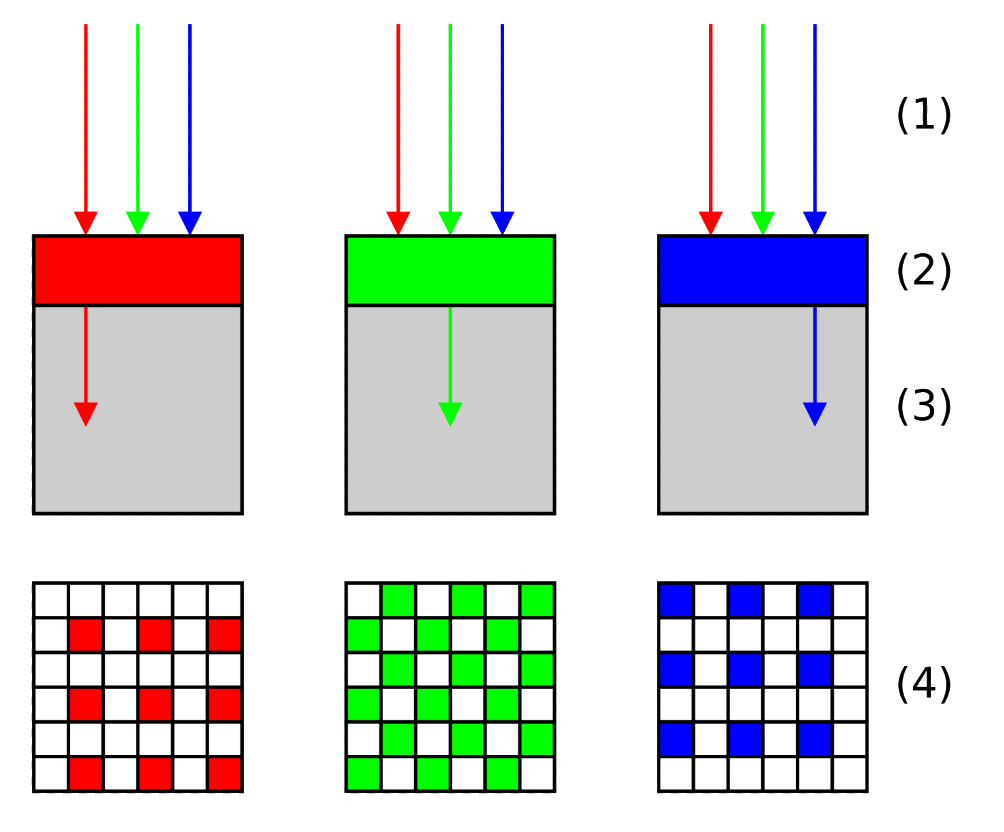

I filtri sono disposti secondo una matrice particolare, chiamata filtro di Bayer (Figure, 3, 4 e 5), in cui ci sono più filtri verdi che filtri rossi e blu, dato che l’occhio umano è più sensibile al verde.

Quando scattiamo una foto con una fotocamera, viene prodotto un file che contiene l’informazione sulla luce per ogni di pixel, mediata da questo filtro.

Non è un’immagine fedele della luce che è passata attraverso l’obiettivo, va elaborata.

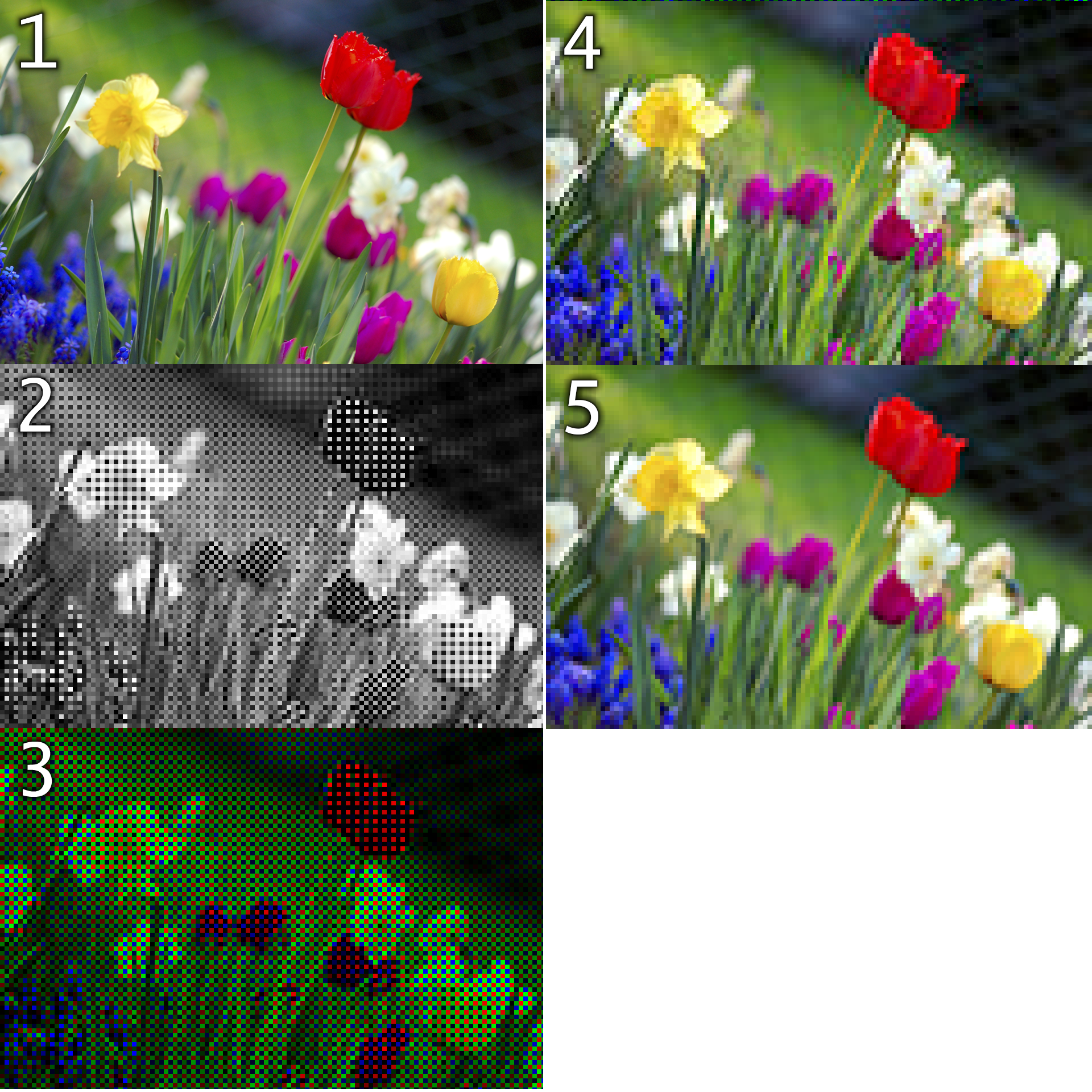

Dopo pochi secondi, sullo schermo della nostra fotocamera appare una bella foto, ammesso che abbiamo scattato bene, ma si tratta di un’elaborazione molto complessa fatta dal computer all’interno della fotocamera, elaborazione su cui non abbiamo alcun controllo.

Quanta luce verde corrisponde a un pixel con un filtro blu o rosso non possiamo saperlo e viceversa, quindi vengono applicati complessi algoritmi di interpolazione per ricostruire l’immagine.

Ovviamente questa ricostruzione ha dei limiti e se dietro a quel pixel blu c’era un puntino rosso corrispondente a un semaforo stradale molto lontano, non lo sapremo mai.

Se abbiamo scattato in formato RAW, cioè nativo della fotocamera, quello che avremo in mano è un file, non un’immagine, che va ancora elaborato, cosa che possiamo fare manualmente con un computer, cosa che ci dà modo di fare delle scelte.

Se abbiamo scattato in formato JPG, avremo l’immagine che abbiamo visto sullo schermo.

Con un cellulare dotato di un sensore molto piccolo e quindi con caratteristiche molto diverse e non in grado di competere con quelli di una macchina fotografica, il computer del telefono esegue altri calcoli aggiuntivi per restituire un’immagine “accettabile”, calcoli che non conosco nel dettaglio, ma di cui vedo gli effetti finali sul mio dispositivo.

Quindi cos’è una foto e cosa non è una foto?

Nell’immagine di EHT vediamo una ricostruzione della mappa rappresentante l’emissione nella banda radio, a una frequenza di 230 GHz e quindi parliamo di radiazione con una lunghezza d’onda di circa 1.3 mm.

I nostri occhi non possono vedere questa radiazione, ma la distribuzione dell’emissione è questa ed è conforme a quello che ci si aspetta di vedere da questo sistema.

Esistono tanti modi per “vedere” i fenomeni astronomici, che possiamo solo osservare da lontano.

Alcuni portano ad immagini, altri no, ma non per questo sono meno diretti.